Über den Vortrag von Bernd Flessner zur Zukunft des Lesens

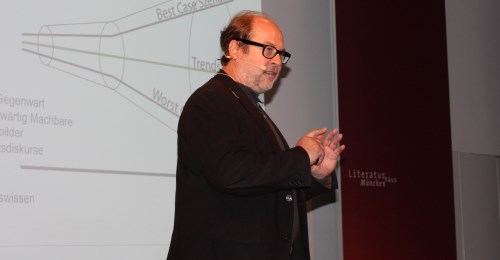

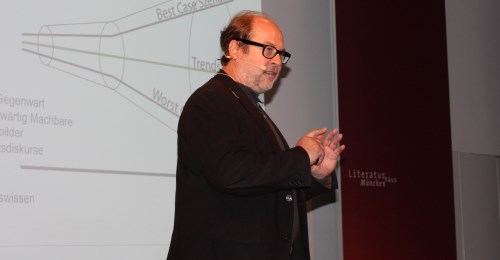

Der Zukunftsforscher Dr. Bernd Flessner von der Friedrich-Alexander-Universität Erlangen-Nürnberg hielt am 20. September im Rahmen der Jahrestagung der Internationalen Buchwissenschaftlichen Gesellschaft (IBG) zur „Zukunft des Lesens“ im Literaturhaus München einen Vortrag unter dem Titel „Streifzüge ins Übermorgen“. Hier beschrieb Flessner sein Szenario der Zukunft des Lesens, angefangen bei den ersten Erfindungen, die sich mit der Kulturtechnik des Lesens und Schreibens beschäftigen, bis zur Revolution der Künstlichen Intelligenz und Big Data. Mediale Privatarchive wie Bibliotheken, CD-Sammlungen etc. verschwinden damit faktisch. An ihre Stelle treten Clouds, Streaming- und On-Demand-Dienste. Marlena Simmet berichtet für uns über diese ambivalent anmutenden Zukunftsperspektive.

*

Seinen Vortrag beginnt Bernd Flessner damit, die Vorgehensweise eines Zukunftsforschers zu erklären: Um möglichst realistische Szenarien bilden zu können, wird ein sogenannter Möglichkeitsraum erschaffen, eine Art Trichter, der an seinem schmalen Ende die Gegenwart darstellt und dann im Verlauf der möglichen Zukunft in die Breite läuft. Am oberen Ende sind die „Best Case Szenarien“, im linearen Verlauf die „Trendszenarien“ und im unteren Bereich die „Worst Case Szenarien“ angesiedelt. Jener Möglichkeitsraum lässt sich mit rund 50 verschiedenen Methoden bestimmen. Ein Beispiel dafür sind die sogenannten „Portents“ aus der Geschichte.

Unter „Portents“ versteht man Ereignisse, die zwar in der Zukunft liegen, jedoch in der Vergangenheit und der Gegenwart bereits Spuren hinterlassen haben. Flessner bezieht sich in seinem Vortrag vor allem auf Erfindungen, die sich einerseits mit der Kulturtechnik des Lesens und Schreibens befassen und auf der anderen Seite die Vision einer zweiten Schöpfung vertreten.

Bereits Mitte des 18. Jahrhunderts erfand Pierre Jaquet-Droz den „Schreiber“. Eine Maschine, die technisch in der Lage war, dem Menschen das manuelle Schreiben abzunehmen, wenn auch noch in sehr begrenztem Rahmen. 1791 baute Wolfgang von Kempelen eine „Sprechmaschine“, 1845 folgte John Clarks „Eureka Machine“, die lateinische Übersetzungen vornehmen sollte. Mitte des 20. Jahrhunderts kamen dann Science-Fiction-Autoren, wie Roald Dahl und Fritz Leiber auf die Idee, Romane über „Elektronengehirne“ und automatische Maschinen zu schreiben, die in der Lage sind, eigenständig grammatikalische Texte zu verfassen.

Rekonstruktion der Sprechmaschine von Wolfgang von Kempelen an der Universität des Saarlandes Saarbrücken (c) Literaturportal Bayern/Marlena Simmet

2010 entwickelte Stuart Frankel schließlich zusammen mit der CIA und SAP eine Software namens „Quill“, die narrative science erstellen kann, sprich eine Software, die dazu führte, dass es heute den sogenannten robot journalism gibt: Nachrichtentexte, die nicht mehr von Menschenhand, sondern von Algorithmen verfasst werden. 2015 erstellte der Wissenschaftler Michael White dazu eine sogenannte „Unwahrscheinlichkeitsprognose“. Er sprach sich dagegen aus, dass der Journalismus irgendwann tatsächlich zum robot journalism avancieren könnte.

White ist nach Flessner allerdings ein „involvierter Experte“. Den Experten eines Fachgebietes falle es oft sehr schwer, sich mögliche Zukunftsszenarien vorzustellen. Orville Wright, der Erfinder des ersten Flugzeugs, verneinte ebenfalls, dass es jemals möglich sein würde, dass ein Flugobjekt von Paris nach New York fliegen und den Atlantik überqueren könne. Bereits zehn Jahre nach Wrights Aussage war es allerdings so weit.

Science-Fiction-Autoren trafen ihre Voraussagen dagegen sehr viel früher. Warum ist das so? Da involvierte Experten meist so tief in der Thematik stecken, sich mit allen technischen Fragen bestens auskennen und daher auch die noch ungelösten Schwierigkeiten im Blick haben, fehle ihnen der Weitblick, so Flessner. Geben solche Experten eine „Unwahrscheinlichkeitsprognose“ ab, so sei dies paradoxerweise oft ein Indiz für das Eintreffen eines Szenarios.

Die Schlüsselfrage ist deshalb nicht ob, sondern wann ein Szenario eintritt. Und: Welche soziokulturellen Entwicklungen werden auf die Erfindung folgen? Facebook war zunächst auch nur eine rein technische Erfindung, zog aber massive soziokulturelle Veränderungen nach sich. Diese sind weitaus schwieriger vorhersehbar.

Orville Wright (1871-1948), Erfinder des ersten Flugzeugs, um 1905

Bereits 2010 gab es Programme, die in gewissem Rahmen als „kreativ“ zu bezeichnen waren; 2015 waren diese Programme bereits so weit, dass sie ein semantisches Verständnis hatten und lernfähig wurden. 2016 wurde dann sogar ein Film produziert, dessen Drehbuch ausschließlich von einem Algorithmus verfasst wurde. Des Weiteren gab es in jüngster Vergangenheit Ereignisse, wie z.B. die Ausstellung Hello, Robot, in der gezeigt wurde, wie Algorithmen das Layout von Büchern erschaffen. Dieses Jahr fand eine Tagung innerhalb der Medienbranche statt, bei der die Aussage gemacht wurde, dass in fünf Jahren ca. 90 Prozent aller Nachrichtenbeiträge von Algorithmen konzipiert sein werden.

Anhand dieser „Spuren“ kommt Flessner zu folgendem Szenario: Die Revolution der Künstlichen Intelligenz (KI) wird stattfinden. 2037, also in 20 Jahren, werden die Medien nicht mehr vom technischen Schreiben zu trennen sein. Die 4.0-Revolution wird das gesamte konvergente Mediensystem betreffen, so dass auch der Konsument zu einem sogenannten „Prosumenten“ (Producer und Konsument) wird. Jeder wird fähig sein, mitwirken zu können, alle Medien werden maßgeschneidert auf den einzelnen Prosumenten konzipiert sein, wodurch jeder seine individuellen Nachrichten erhält. Die KI nutzt die überall gesammelten Big Data und kennt somit alle Vorlieben des Prosumenten. Die gängigen Redaktions-Diffusions- und Distributionssysteme wird es nicht mehr geben. Autoren, Regisseure und Produzenten, wie wir sie heute kennen, werden 2037 genauso antiquiert sein wie Schuster oder Schmiede. Im postmedialen System wird es Programme geben, die einen Text vorlesen können, so dass man selbst nicht mehr zu lesen braucht. Der User wird sich sogar die Stimme des Vorlesers aussuchen können. Mediale Privatarchive wie Bibliotheken, CD-Sammlungen etc. werden faktisch verschwunden sein. An deren Stelle werden Clouds, Streaming- und On-Demand-Dienste treten.

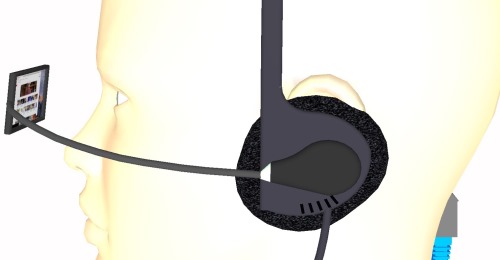

Brain Computer Interface

Flessner zeichnet zum Schluss noch den Verlauf des Zeitalters der technischen Medien. Das Zeitalter begann zunächst mit der Literalität des Buchdrucks, es folgte eine zunehmende Visualität (z.B. immer mehr und größere Bilder in Zeitungen) – eine mögliche Folge daraus wäre eine neue Oligo-Literalität, funktionaler Analphabetismus oder eine hermeneutische Retardierung. Anders gedacht: eine Gleichzeitigkeit von Literalität und Visualität im Bereich des Lesens, so wie es heutzutage eine Gleichzeitigkeit der Nutzung von Theater und Kino gibt.

Flessner lässt weitere Entwicklungen offen, da in diesem Bereich sehr vieles denkbar ist und der Fantasie keine Grenzen gesetzt sind. Der soziokulturelle Bereich ist dabei, wie oben angesprochen, der am schwierigsten vorhersehbare. Betrachtet man z.B. die Schallplatte, so ist diese nicht verschwunden, sondern hat einen Bedeutungswandel erfahren. Sie wird nach wie vor produziert, gilt aber nun als Statussymbol für Liebhaber oder als besonderer Speicherplatz für Lieblingsmusik. Jener Bedeutungswandel war so gut wie nicht vorhersehbar und ist letztlich auch für das Medium Buch denkbar.

Zum Abschluss zeigt Flessner noch ein Foto eines Mikrochips, der sich im Auge eines Blinden befindet, um diesem zu ermöglichen, zumindest annähernd Strukturen der Außenwelt zu erkennen. Dieser Chip wurde dem Patienten bereits 2009 eingesetzt. Flessners These: Als Nächstes wird das Brain Computer Interface entstehen, das die Konvergenz von Mensch und Maschine erlaubt. Im Hinblick darauf sind natürlich alle möglichen positiven wie negativen Zukunftsvorstellungen möglich.

Zur Tagung „Die Zukunft des Lesens“

Wie werden wir in zwanzig, dreißig oder fünfzig Jahren lesen? Vernetzen sich autonom agierende Lesegeräte miteinander und tauschen abgestimmt auf die Bedürfnisse und Lesegewohnheiten des Nutzers Informationen und Geschichten aus? Stimmen Leser via App über alternative Enden eines multisensorischen Romans ab? Werden Verlage zu Rechenzentren und Distributoren hybrider Texte und Buchhandlungen und Bibliotheken zum Treffpunkt für Digital Natives?

Die Zukunft als Möglichkeitsraum bietet viel Platz für Visionen, Spekulationen und Gestaltungsfreiheiten, wie wir künftig lesen wollen. Bereits aktuelle Debatten sind geprägt durch den umfassenden Wandel, den die Digitalisierung und damit verbundene technologische Innovationen in nahezu allen Bereichen unserer Gesellschaft auslösen.

Welchen Stellenwert und welche Bedeutung hat das Lesen dann noch in der Gesellschaft? Welche Auswirkungen auf den Prozess des Lesen(lernen)s haben Bildschirmmedien? Wie reagieren Verlage, Buchhandel und Bibliotheken auf die Veränderungen im Leseverhalten? Müssen Bildungsträger, wie Kindertagesstätten und Schulen, Kinder und Jugendliche anders an das Lesen heranführen?

Die Jahrestagung der Internationalen Buchwissenschaftlichen Gesellschaft (IBG) versammelte Vertreter aus Wissenschaft, pädagogischer und unternehmerischer Praxis, der Kulturpolitik und nicht zuletzt Leser zum fachlichen Austausch und offenen Diskurs über Szenarien, Umbrüche und Visionen der Kulturtechnik Lesen.

Veranstalter: Internationale Buchwissenschaftliche Gesellschaft (IBG) München in Kooperation mit Buchwissenschaft/LMU Forschungsstelle Werteerziehung und Lehrerbildung/LMU und Literaturhaus München. Die Tagung wurde mit freundlicher Unterstützung der Waldemar-Bonsels-Stiftung (München) und der Verlagsgruppe Random House gefördert.

Über den Vortrag von Bernd Flessner zur Zukunft des Lesens

Der Zukunftsforscher Dr. Bernd Flessner von der Friedrich-Alexander-Universität Erlangen-Nürnberg hielt am 20. September im Rahmen der Jahrestagung der Internationalen Buchwissenschaftlichen Gesellschaft (IBG) zur „Zukunft des Lesens“ im Literaturhaus München einen Vortrag unter dem Titel „Streifzüge ins Übermorgen“. Hier beschrieb Flessner sein Szenario der Zukunft des Lesens, angefangen bei den ersten Erfindungen, die sich mit der Kulturtechnik des Lesens und Schreibens beschäftigen, bis zur Revolution der Künstlichen Intelligenz und Big Data. Mediale Privatarchive wie Bibliotheken, CD-Sammlungen etc. verschwinden damit faktisch. An ihre Stelle treten Clouds, Streaming- und On-Demand-Dienste. Marlena Simmet berichtet für uns über diese ambivalent anmutenden Zukunftsperspektive.

*

Seinen Vortrag beginnt Bernd Flessner damit, die Vorgehensweise eines Zukunftsforschers zu erklären: Um möglichst realistische Szenarien bilden zu können, wird ein sogenannter Möglichkeitsraum erschaffen, eine Art Trichter, der an seinem schmalen Ende die Gegenwart darstellt und dann im Verlauf der möglichen Zukunft in die Breite läuft. Am oberen Ende sind die „Best Case Szenarien“, im linearen Verlauf die „Trendszenarien“ und im unteren Bereich die „Worst Case Szenarien“ angesiedelt. Jener Möglichkeitsraum lässt sich mit rund 50 verschiedenen Methoden bestimmen. Ein Beispiel dafür sind die sogenannten „Portents“ aus der Geschichte.

Unter „Portents“ versteht man Ereignisse, die zwar in der Zukunft liegen, jedoch in der Vergangenheit und der Gegenwart bereits Spuren hinterlassen haben. Flessner bezieht sich in seinem Vortrag vor allem auf Erfindungen, die sich einerseits mit der Kulturtechnik des Lesens und Schreibens befassen und auf der anderen Seite die Vision einer zweiten Schöpfung vertreten.

Bereits Mitte des 18. Jahrhunderts erfand Pierre Jaquet-Droz den „Schreiber“. Eine Maschine, die technisch in der Lage war, dem Menschen das manuelle Schreiben abzunehmen, wenn auch noch in sehr begrenztem Rahmen. 1791 baute Wolfgang von Kempelen eine „Sprechmaschine“, 1845 folgte John Clarks „Eureka Machine“, die lateinische Übersetzungen vornehmen sollte. Mitte des 20. Jahrhunderts kamen dann Science-Fiction-Autoren, wie Roald Dahl und Fritz Leiber auf die Idee, Romane über „Elektronengehirne“ und automatische Maschinen zu schreiben, die in der Lage sind, eigenständig grammatikalische Texte zu verfassen.

Rekonstruktion der Sprechmaschine von Wolfgang von Kempelen an der Universität des Saarlandes Saarbrücken (c) Literaturportal Bayern/Marlena Simmet

2010 entwickelte Stuart Frankel schließlich zusammen mit der CIA und SAP eine Software namens „Quill“, die narrative science erstellen kann, sprich eine Software, die dazu führte, dass es heute den sogenannten robot journalism gibt: Nachrichtentexte, die nicht mehr von Menschenhand, sondern von Algorithmen verfasst werden. 2015 erstellte der Wissenschaftler Michael White dazu eine sogenannte „Unwahrscheinlichkeitsprognose“. Er sprach sich dagegen aus, dass der Journalismus irgendwann tatsächlich zum robot journalism avancieren könnte.

White ist nach Flessner allerdings ein „involvierter Experte“. Den Experten eines Fachgebietes falle es oft sehr schwer, sich mögliche Zukunftsszenarien vorzustellen. Orville Wright, der Erfinder des ersten Flugzeugs, verneinte ebenfalls, dass es jemals möglich sein würde, dass ein Flugobjekt von Paris nach New York fliegen und den Atlantik überqueren könne. Bereits zehn Jahre nach Wrights Aussage war es allerdings so weit.

Science-Fiction-Autoren trafen ihre Voraussagen dagegen sehr viel früher. Warum ist das so? Da involvierte Experten meist so tief in der Thematik stecken, sich mit allen technischen Fragen bestens auskennen und daher auch die noch ungelösten Schwierigkeiten im Blick haben, fehle ihnen der Weitblick, so Flessner. Geben solche Experten eine „Unwahrscheinlichkeitsprognose“ ab, so sei dies paradoxerweise oft ein Indiz für das Eintreffen eines Szenarios.

Die Schlüsselfrage ist deshalb nicht ob, sondern wann ein Szenario eintritt. Und: Welche soziokulturellen Entwicklungen werden auf die Erfindung folgen? Facebook war zunächst auch nur eine rein technische Erfindung, zog aber massive soziokulturelle Veränderungen nach sich. Diese sind weitaus schwieriger vorhersehbar.

Orville Wright (1871-1948), Erfinder des ersten Flugzeugs, um 1905

Bereits 2010 gab es Programme, die in gewissem Rahmen als „kreativ“ zu bezeichnen waren; 2015 waren diese Programme bereits so weit, dass sie ein semantisches Verständnis hatten und lernfähig wurden. 2016 wurde dann sogar ein Film produziert, dessen Drehbuch ausschließlich von einem Algorithmus verfasst wurde. Des Weiteren gab es in jüngster Vergangenheit Ereignisse, wie z.B. die Ausstellung Hello, Robot, in der gezeigt wurde, wie Algorithmen das Layout von Büchern erschaffen. Dieses Jahr fand eine Tagung innerhalb der Medienbranche statt, bei der die Aussage gemacht wurde, dass in fünf Jahren ca. 90 Prozent aller Nachrichtenbeiträge von Algorithmen konzipiert sein werden.

Anhand dieser „Spuren“ kommt Flessner zu folgendem Szenario: Die Revolution der Künstlichen Intelligenz (KI) wird stattfinden. 2037, also in 20 Jahren, werden die Medien nicht mehr vom technischen Schreiben zu trennen sein. Die 4.0-Revolution wird das gesamte konvergente Mediensystem betreffen, so dass auch der Konsument zu einem sogenannten „Prosumenten“ (Producer und Konsument) wird. Jeder wird fähig sein, mitwirken zu können, alle Medien werden maßgeschneidert auf den einzelnen Prosumenten konzipiert sein, wodurch jeder seine individuellen Nachrichten erhält. Die KI nutzt die überall gesammelten Big Data und kennt somit alle Vorlieben des Prosumenten. Die gängigen Redaktions-Diffusions- und Distributionssysteme wird es nicht mehr geben. Autoren, Regisseure und Produzenten, wie wir sie heute kennen, werden 2037 genauso antiquiert sein wie Schuster oder Schmiede. Im postmedialen System wird es Programme geben, die einen Text vorlesen können, so dass man selbst nicht mehr zu lesen braucht. Der User wird sich sogar die Stimme des Vorlesers aussuchen können. Mediale Privatarchive wie Bibliotheken, CD-Sammlungen etc. werden faktisch verschwunden sein. An deren Stelle werden Clouds, Streaming- und On-Demand-Dienste treten.

Brain Computer Interface

Flessner zeichnet zum Schluss noch den Verlauf des Zeitalters der technischen Medien. Das Zeitalter begann zunächst mit der Literalität des Buchdrucks, es folgte eine zunehmende Visualität (z.B. immer mehr und größere Bilder in Zeitungen) – eine mögliche Folge daraus wäre eine neue Oligo-Literalität, funktionaler Analphabetismus oder eine hermeneutische Retardierung. Anders gedacht: eine Gleichzeitigkeit von Literalität und Visualität im Bereich des Lesens, so wie es heutzutage eine Gleichzeitigkeit der Nutzung von Theater und Kino gibt.

Flessner lässt weitere Entwicklungen offen, da in diesem Bereich sehr vieles denkbar ist und der Fantasie keine Grenzen gesetzt sind. Der soziokulturelle Bereich ist dabei, wie oben angesprochen, der am schwierigsten vorhersehbare. Betrachtet man z.B. die Schallplatte, so ist diese nicht verschwunden, sondern hat einen Bedeutungswandel erfahren. Sie wird nach wie vor produziert, gilt aber nun als Statussymbol für Liebhaber oder als besonderer Speicherplatz für Lieblingsmusik. Jener Bedeutungswandel war so gut wie nicht vorhersehbar und ist letztlich auch für das Medium Buch denkbar.

Zum Abschluss zeigt Flessner noch ein Foto eines Mikrochips, der sich im Auge eines Blinden befindet, um diesem zu ermöglichen, zumindest annähernd Strukturen der Außenwelt zu erkennen. Dieser Chip wurde dem Patienten bereits 2009 eingesetzt. Flessners These: Als Nächstes wird das Brain Computer Interface entstehen, das die Konvergenz von Mensch und Maschine erlaubt. Im Hinblick darauf sind natürlich alle möglichen positiven wie negativen Zukunftsvorstellungen möglich.

Zur Tagung „Die Zukunft des Lesens“

Wie werden wir in zwanzig, dreißig oder fünfzig Jahren lesen? Vernetzen sich autonom agierende Lesegeräte miteinander und tauschen abgestimmt auf die Bedürfnisse und Lesegewohnheiten des Nutzers Informationen und Geschichten aus? Stimmen Leser via App über alternative Enden eines multisensorischen Romans ab? Werden Verlage zu Rechenzentren und Distributoren hybrider Texte und Buchhandlungen und Bibliotheken zum Treffpunkt für Digital Natives?

Die Zukunft als Möglichkeitsraum bietet viel Platz für Visionen, Spekulationen und Gestaltungsfreiheiten, wie wir künftig lesen wollen. Bereits aktuelle Debatten sind geprägt durch den umfassenden Wandel, den die Digitalisierung und damit verbundene technologische Innovationen in nahezu allen Bereichen unserer Gesellschaft auslösen.

Welchen Stellenwert und welche Bedeutung hat das Lesen dann noch in der Gesellschaft? Welche Auswirkungen auf den Prozess des Lesen(lernen)s haben Bildschirmmedien? Wie reagieren Verlage, Buchhandel und Bibliotheken auf die Veränderungen im Leseverhalten? Müssen Bildungsträger, wie Kindertagesstätten und Schulen, Kinder und Jugendliche anders an das Lesen heranführen?

Die Jahrestagung der Internationalen Buchwissenschaftlichen Gesellschaft (IBG) versammelte Vertreter aus Wissenschaft, pädagogischer und unternehmerischer Praxis, der Kulturpolitik und nicht zuletzt Leser zum fachlichen Austausch und offenen Diskurs über Szenarien, Umbrüche und Visionen der Kulturtechnik Lesen.

Veranstalter: Internationale Buchwissenschaftliche Gesellschaft (IBG) München in Kooperation mit Buchwissenschaft/LMU Forschungsstelle Werteerziehung und Lehrerbildung/LMU und Literaturhaus München. Die Tagung wurde mit freundlicher Unterstützung der Waldemar-Bonsels-Stiftung (München) und der Verlagsgruppe Random House gefördert.